# 数据去重工具

# 一、简介

数据去重工具主要用于将 TA 系统中的重复的事件数据去重处理,支持根据时间段以及事件类型去重事件数据。

因为去重会占用集群计算资源,我们建议只在数据异常时进行数据去重,不建议作为频繁去重数据,请谨慎使用本工具。

# 二、使用说明

数据去重工具只支持私有化服务的用户使用。root 用户登录私有化集群的任意一台服务器,执行su - ta

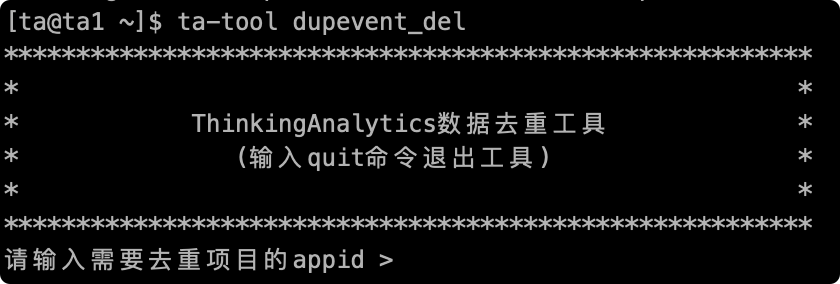

然后执行ta-tool dupevent_del,即可进入数据去重工具界面。

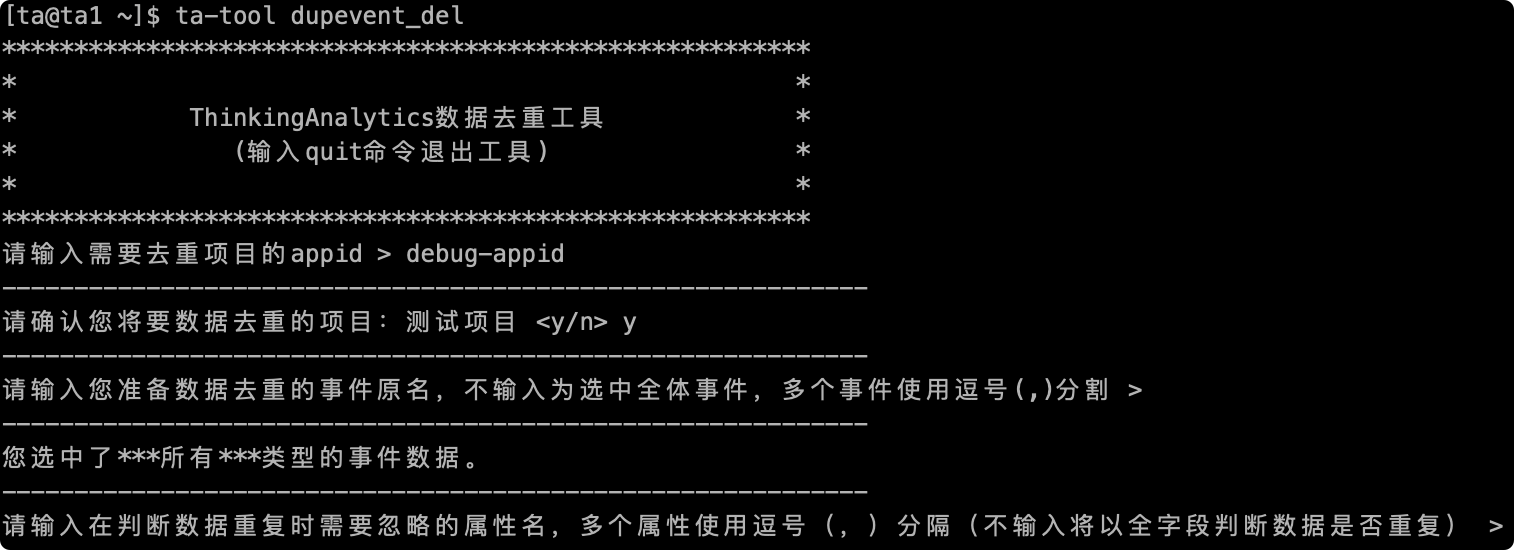

# 2.1 填写需处理项目的 appid

项目的 appid 可在 TA 后台中的项目管理页面中查询。

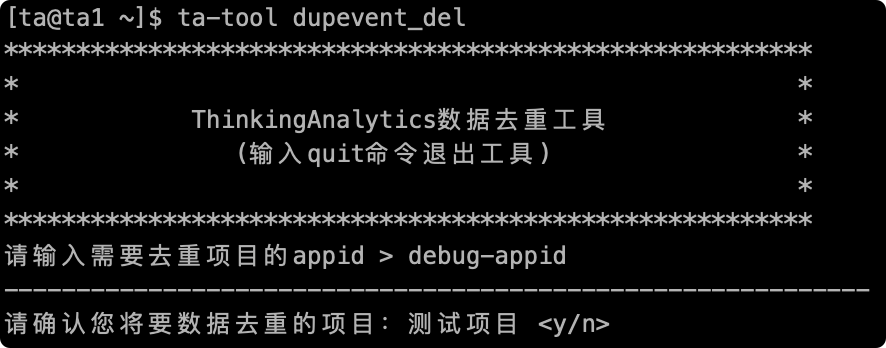

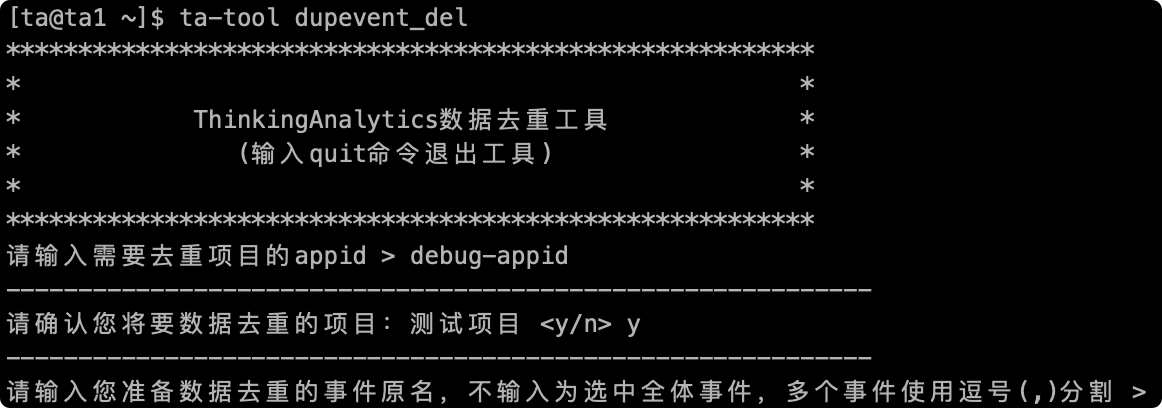

# 2.2 确认项目名称

输入完毕后会提示需要去重的项目的项目名,输入"y"进行确认,输入"n"取消操作

# 2.3 填写需要去重的事件名

接下来需要输入去重事件的事件名,此处输入的事件名是传输数据时的 key 值,不是显示名,可在元数据管理页面中查询事件名,去重多个事件可用","分割,输入完毕后会提示将要去重的事件名。

如果不输入任何字符直接回车确认,视为去重所有事件数据:

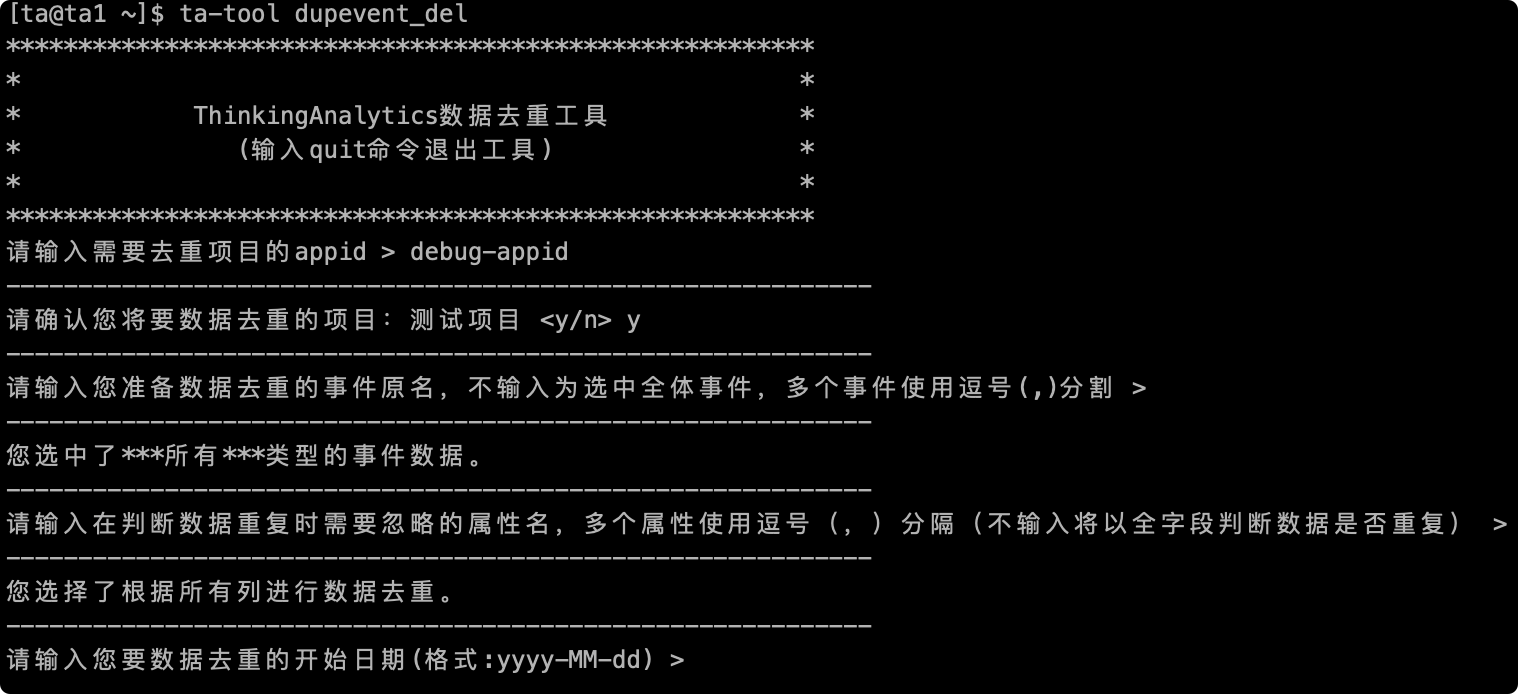

# 2.4 填写在去重逻辑中忽略的列名

接下来需要输入判断去重逻辑忽略的字段名,默认已经去掉 ta 自用字段参与重复逻辑判断,例如"#server_time","#kafka_offset"字段不参与重复判断逻辑,忽略多个字段可用","分割,输入完毕后会提示将要忽略的字段名。

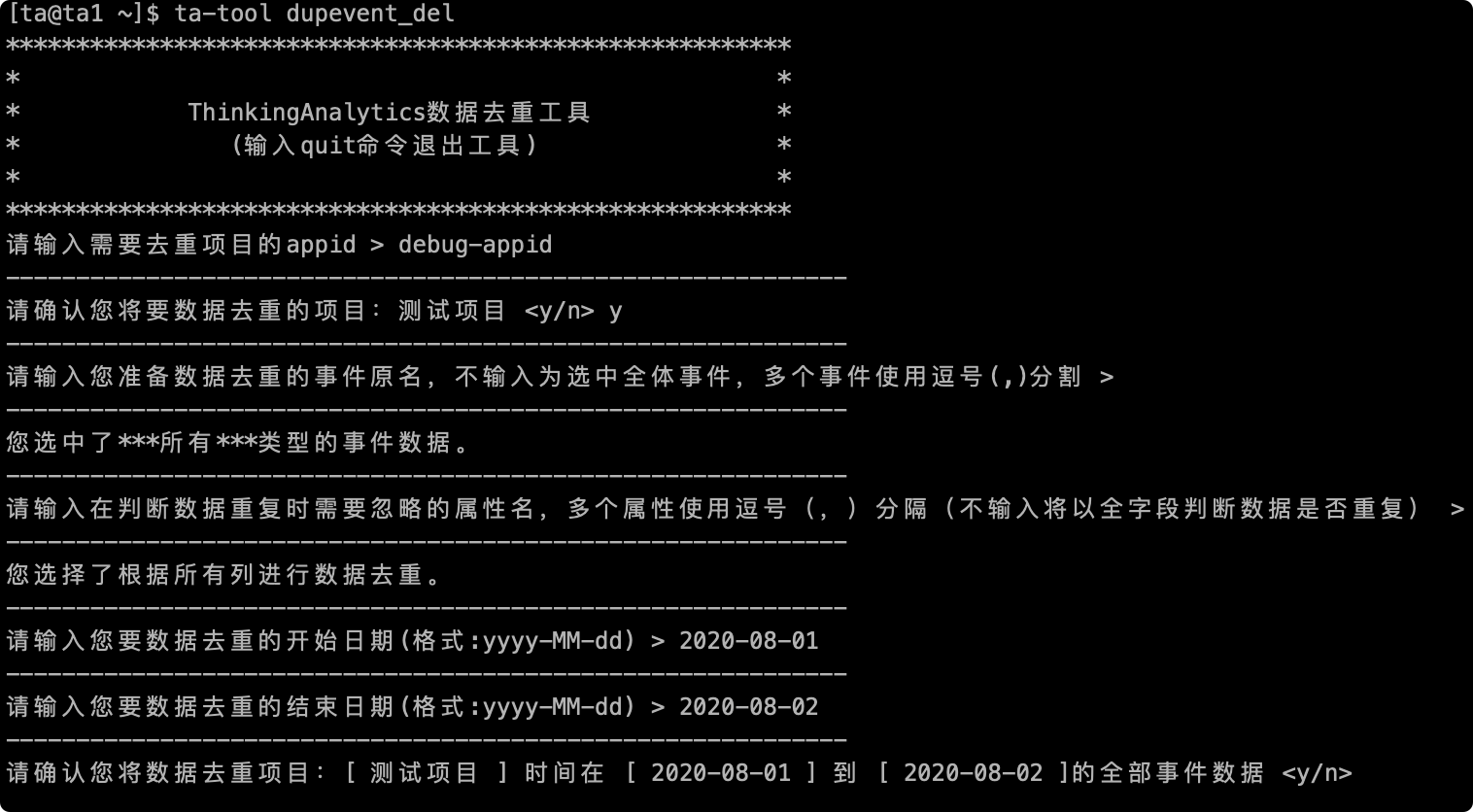

# 2.5 填写去重事件数据的时间范围

接下来需要输入去重数据的时间段,可选的时间颗粒度为“天”,请以yyyy-MM-dd的格式输入日期,此项为必输项):

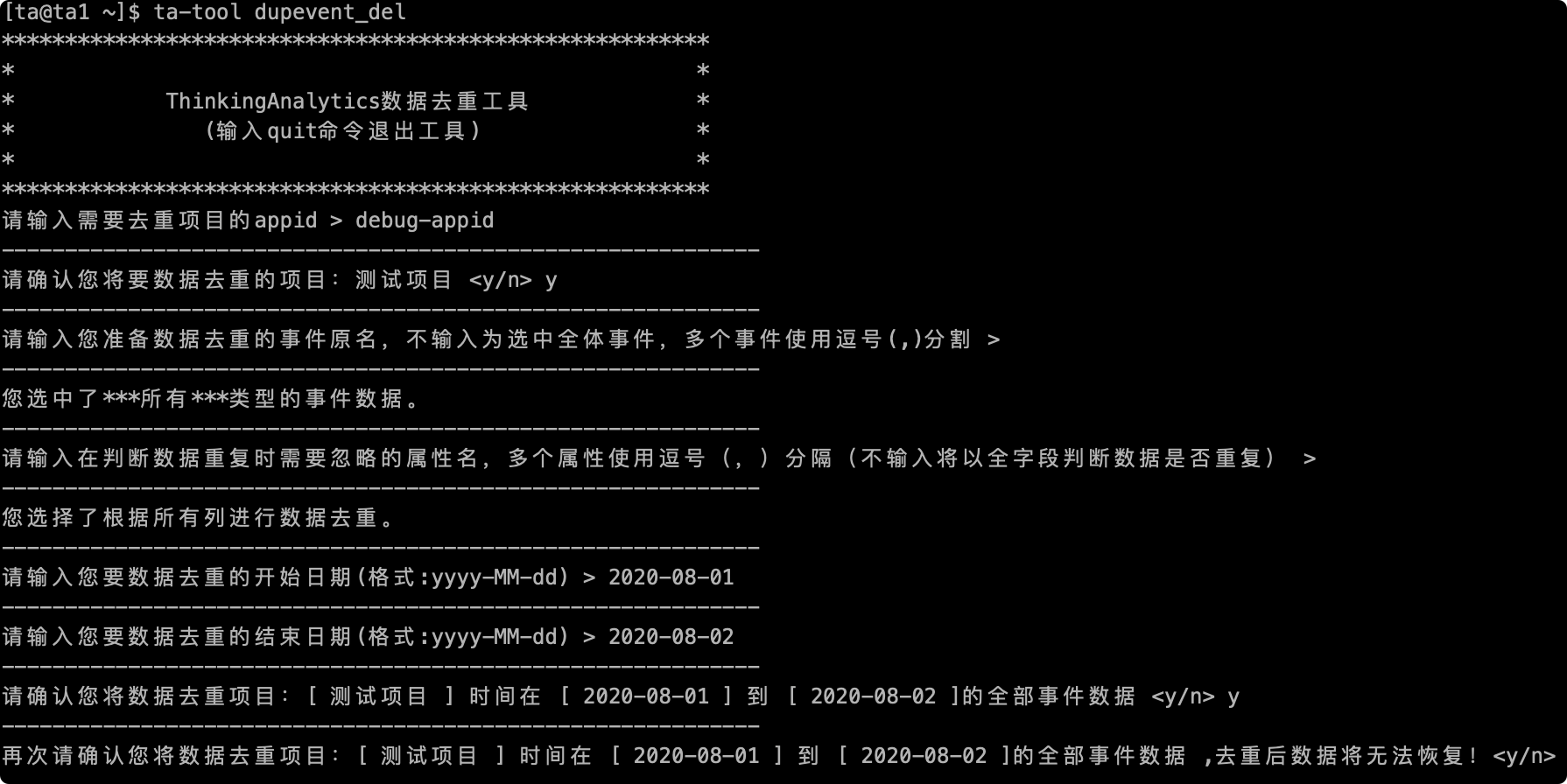

# 2.6 最终确认

最后在数据去重前,会进行最后的确认,包括去重项目的名称,去重事件的名称以及去重的时段,输入"y"开始处理数据,如有错误可输入"n"退出工具重新输入:

# 2.7 完整执行流程

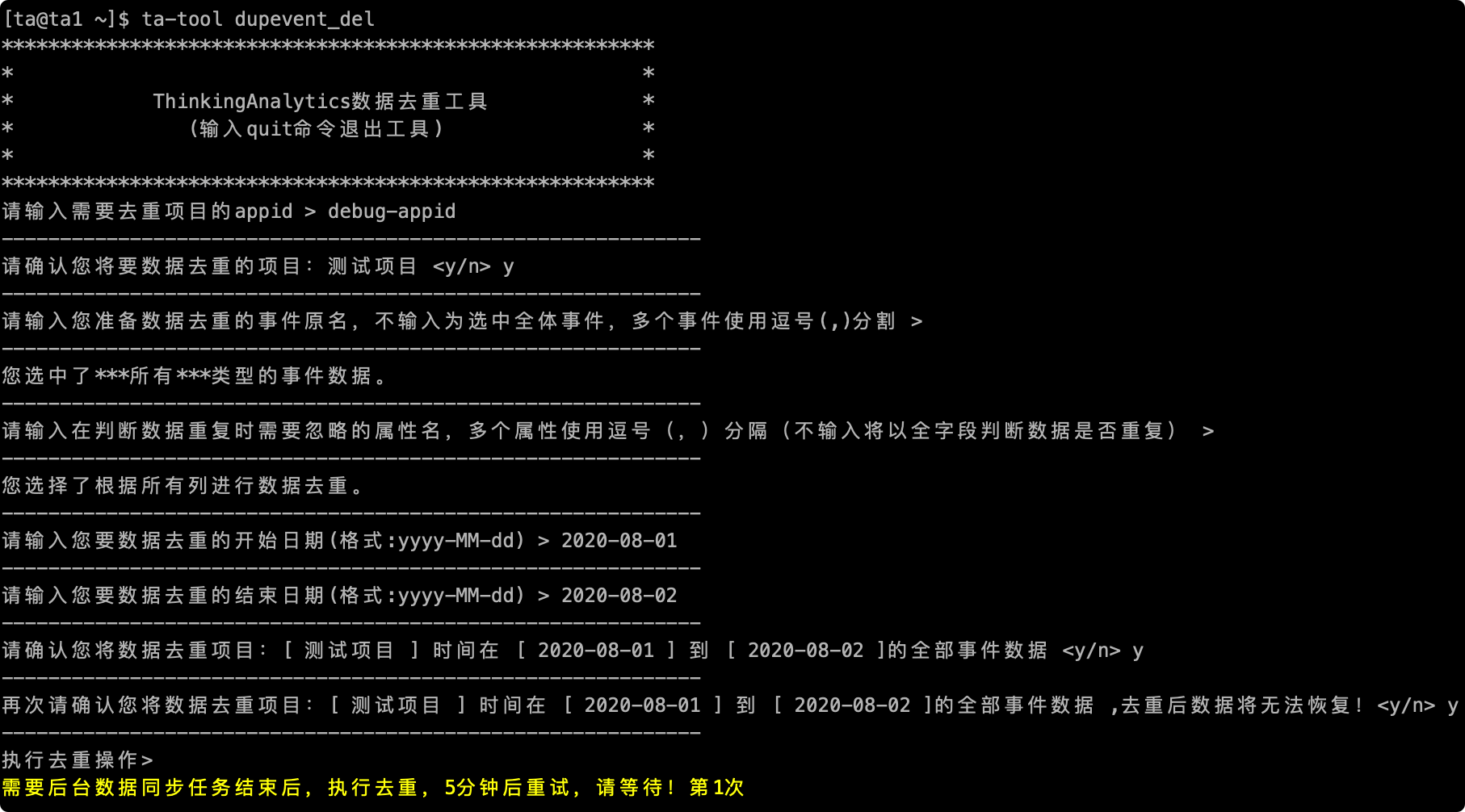

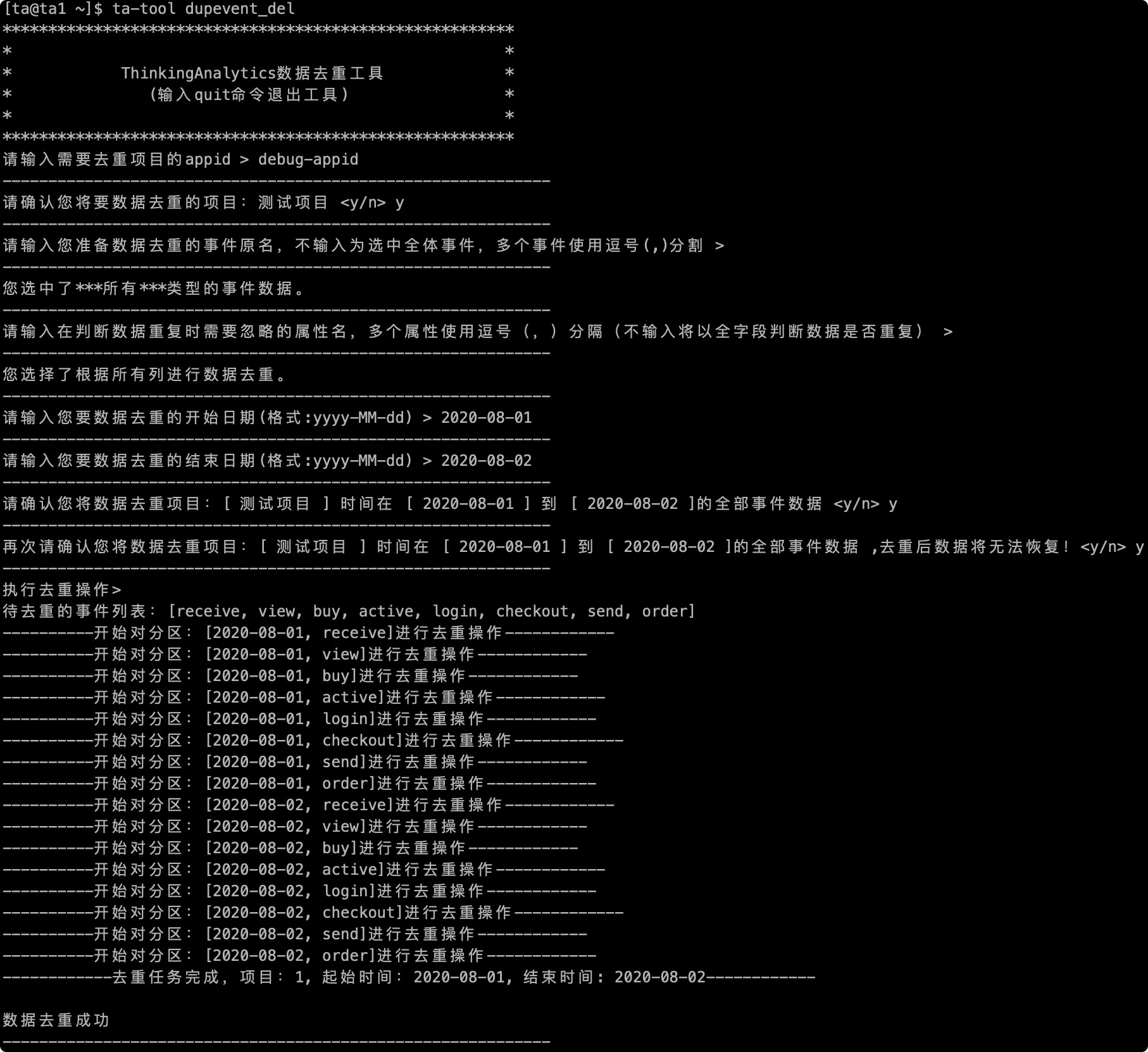

确认后会进行数据去重,如下图去重整个流程截图:

# 三、注意事项

# 1 在使用数据去重工具前,请确认好数据重复原因,避免去重同时有重复数据进入,无法保证去重效果。

# 2 去重需要占用集群计算资源,不建议频繁使用。

# 3 如果出现如下截图情况,是集群在进行数据合并,可以等待他自己自动执行,如果长时间卡在次处可以联系运维人员排查。